אם אתם בעלי אתר, כנראה גם אתם רוצים להיות מבין אותם "מובחרים" ולהיות מדורגים גבוה בתוצאות החיפוש של גוגל.

אם רק נבין איך גוגל קובע את הדירוג הזה, שזה מה שעושים במסגרת תהליך קידום אתרים מקצועי ברשת, אולי יהיה לנו סיכוי להגיע לשם.

בשביל לענות על שאלת מיליון הדולר, כדאי שנלך אחורה כמה צעדים וננסה להבין איך מנוע החיפוש של גוגל בכלל עובד, איך הוא יודע כל כך הרבה על האינטרנט, ואיך הוא מתאים את התוצאות שלו לשאלות החיפוש שלנו?

אם נבין איך גוגל עובד (אפילו במקצת) ולמה הם מכוונים, נוכל להיות מקדמי אתרים טובים יותר ולעשות SEO כמו שצריך.

בין הנושאים שעליהם אפרט במאמר:

- איך עובדת גוגל בקידום אורגני באופן כללי

- מנוע החיפוש של גוגל

- זוחלים / עכבישים (Web Spiders / Crawlers)

- אינדקס החיפוש

- HTML

- מילות מפתח

- איך לייצר אתר "סריק" (Crawlable)

- קובץ Robots.txt

- מפת אתר

- פרמטרים עיקריים לדירוג בגוגל

שנתחיל?

חברת גוגל (Google) הקימה את מנוע החיפוש גוגל (שבהתחלה נקרא "Backrub") בשנת 1998 כדי לתת מענה כמה שיותר מהיר, מדויק, רלוונטי ואיכותי לשאלות החיפוש שלנו.

סך הכול, הוא עושה עבודה טובה. לכן הוא נעשה כל כך פופולארי, שימושי וסמכותי.

אם בא לכם להתחיל עם סרטון קצר שבו אני מסביר (בקטנה) איך גוגל עובד, אתם מוזמנים:

אז איך עובדת גוגל בקידום אורגני?

כשאנו עושים חיפוש בגוגל, אנו למעשה מחפשים באינדקס של גוגל

נשמע מובן מאליו? אולי.

אבל חשוב להבין שמדובר בחיפוש באינדקס ולא בתוצאות בזמן אמת.

כל שאילתא (מחרוזת חיפוש) שאנו מקישים בגוגל, שיכולה להיות מורכבת ממילה אחת או הרבה יותר, למעשה תפקידה להחזיר את התוצאות הרלוונטיות ביותר מתוך האינדקס של גוגל (התוצאות שגוגל כבר סרק ושמר בארכיון שלו) והכל בשברירי שניה.

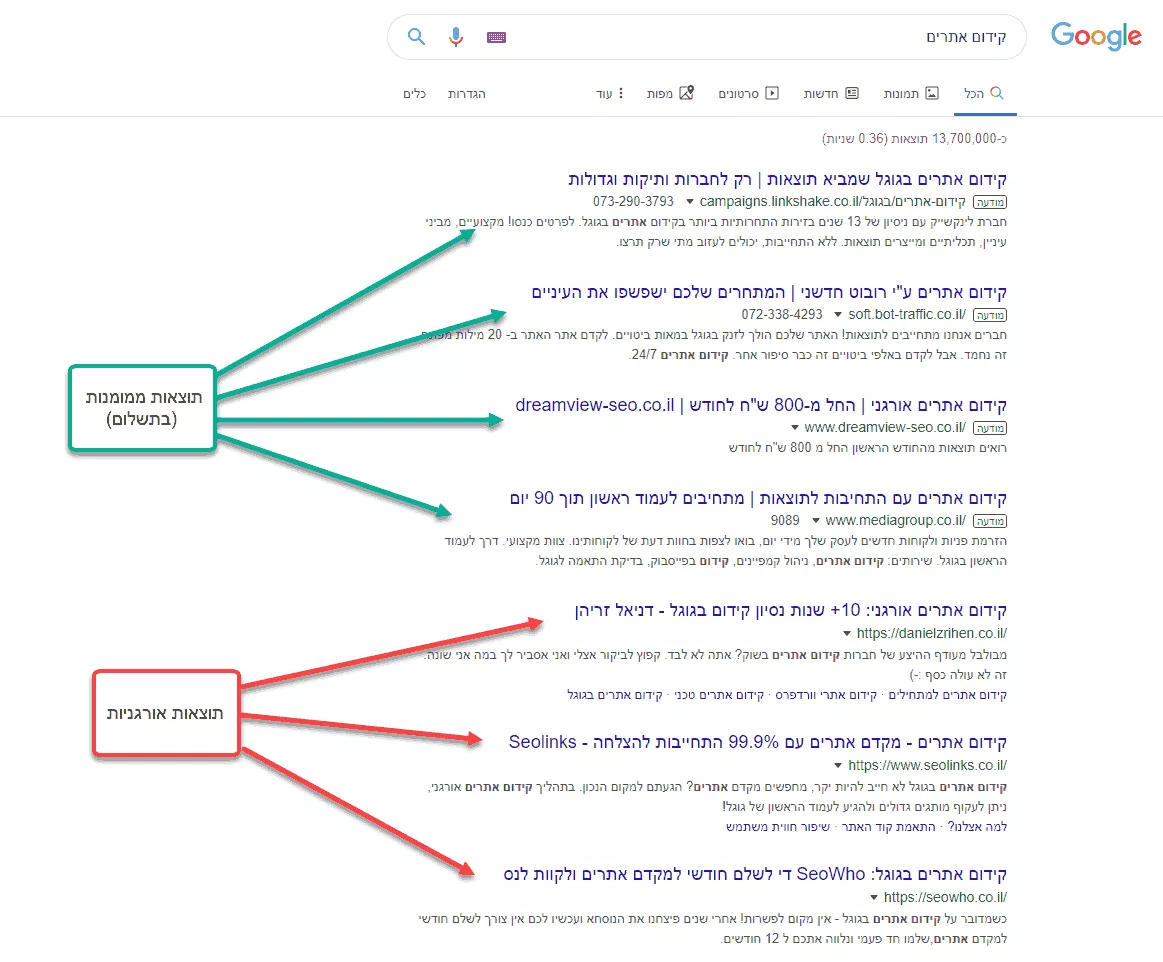

לפני שנמשיך הלאה, אדגיש שאני מדבר על תוצאות אורגניות בלבד. למי שלא מכיר – זאת החלוקה:

על מנת לראות את הפוטנציאל האורגני ותוך כמה זמן נכפיל לך את ההכנסות

ניתן לחייג למספר 052-9095200 או למלא את הטופס:

השיטה של פרסום בגוגל עובדת אחרת – גם שם יש אלמנט של סריקה, אבל לא כמו התוצאות האורגניות.

כל כמה זמן גוגל סורק ומאנדקס אתרים?

התשובה לכך מאד משתנה מאתר לאתר.

יש אתרים שנסרקים בתדירות גבוהה מאד (אחת ליום או כמה פעמים ביום) – לדוגמא, אתרים בעלי אופי חדשותי ובאופן כללי אתרים חזקים שמקבלים קישורים רבים (כל קישור מעודד את העכבישים של גוגל לסרוק אותו ואת הדפים שהוא מוביל אליהם, לכן אתר המקבל קישורים רבים גם ייסרק בתדירות גבוהה יותר).

לעומת זאת – אתרים חדשים או אתרים פחות פופולאריים (שלא זוכים לקישורים רבים) ייסרקו בתדירות נמוכה יותר – זה יכול להיות אחת לשבוע, אחת לשבועיים ואפילו אחת לחודש באתרים ממש חדשים ו/או לא מוכרים.

זאת הסיבה שזה די נפוץ לראות תוצאה מקדימה בגוגל (Snippet) שמראה X למרות שתוכן האתר השתנה מאז ומראה Y – פשוט הזחלנים של גוגל עדיין לא אינדקסו את התוצאה מאז העדכון האחרון שבוצע בה.

לבעלי אתרים ומקדמי אתרים, יש דרך לסרוק ולאנדקס עמודים מהר יותר, גם בצורה מיידית – על ידי בקשה בקונסול של גוגל. למידע נוסף קיראו: איך להוסיף אתר לגוגל במהירות.

גוגל כספריה

הדרך הכי טובה להבין איך גוגל עובד – זה לחשוב על האינטרנט כספריה ענקית.

יש בספרייה הזאת מאות מיליונים של ספרים, מאמרים, סרטים ותמונות.

היא גם כל הזמן גדלה ומתרחבת והפריטים בה עוברים עריכות ושינויים על ידי המחברים באופן עצמאי. אבל אין לספריה הזאת מערכת תיוק מרכזית.

זה בעצם התפקיד של גוגל.

איך הוא עושה את זה?

לגוגל יש מה שנקרא בוטים.

אפשר לקרוא להם גם "זוחלים" (Crawlers) או "עכבישים" (Spiders). הם בעצם מזדחלים ברחבי האינטרנט ומדווחים לגוגל את מה שהם מגלים בדרך.

הזוחלים האלה מסתובבים חופשי באינטרנט, עוברים מדף לדף, סוקרים אותם ושולחים לגוגל את המידע לתיוק. התיוק הזה נקרא "לאנדקס" או "אינדוקס" (מאנגלית, to index).

העכבישים למעשה עוקבים אחרי קישורים פנימיים וחיצוניים, מוצאים ועוד ועוד דפי אינטרנט וככה האינדקס של גוגל גדל כל הזמן.

* הידעת? בגוגל יש כיום למעלה מ-130 טריליון דפים מאונדקסים!

מאט קאטס, לשעבר בכיר בגוגל, מסביר את כל זה בצורה מאד ידידותית וברורה בסרטון הבא:

נשמע מלחיץ… ומה זה HTML?

האופן שבו הזוחלים קוראים את האתרים ואופן שבו הם עוברים מאתר לאתר רלוונטי על מנת להבין כיצד גוגל רואה את האתר שלנו.

חשוב להבין שהזוחלים האלה לא רואים את האתרים והדפים השונים כמו שאנחנו רואים אותם באופן ויזואלי דרך הדפדפן. הם בעצם מסתכלים מתחת למכסה המנוע של האתר וקוראים את קוד שממנו הדפים בנויים.

HTML היא השפה הבסיסית שעליה מבוססים רוב אתרי האינטרנט.

גם אתרים הבנויים בפלטפורמה מבוססת PHP (וורדפרס למשל) או ASP ואחרות – בסופו של דבר מייצרות עמודי HTML הנגישים לסריקה של גוגל.

קריאת קוד ה-HTML של האתר מלמדת את הזוחלים מה בעצם יש באתר, מה התוכן שלו. הם שולחים את המידע הזה לגוגל לאינדוקס.

זו אחת הסיבות שבגללה מומלץ לכל אחד – בין אם אתם מומחי SEO ובין אם אתם פשוט רוצים להעלות את הדירוג של האתר שלכם – להבין, לפחות באופן בסיסי, מה זה תכנות בשפת HTML ואיך זה עובד.

חשוב מאד שנבנה את האתר שלנו כך שלגוגל יהיה קל להבין מה יש בו, כדי שיאנדקס אותו בהתאם למטרות שהגדרנו מראש.

מה קורה לאחר שלב הסריקה והאינדוקס?

לעכבישים של גוגל יש יכולת לזהות באיזה נושא עוסק כל דף אינטרנט, מתוך חילוץ מילות המפתח העיקריות שבדף, ובכך להציג אותו עבור שאילתא רלוונטית.

כמובן, שעצם נוכחות מילות מפתח מסוימות בדף לא הופכת אותו מיד לתוצאה רלוונטית – זה היה אולי נכון בשנת 2000, במנועי החיפוש הראשונים, אבל כיום גוגל ומנועי חיפוש אחרים הרבה יותר מתוחכמים.

כך למשל, גוגל לוקח בחשבון מעל 200 פרמטרים שונים (!) על מנת לקבוע ציון רלוונטיות לכל דף ספציפי עבור שאילתא ספציפית. על מעל 100 גורמים כאלה, כתבתי במדריך הזה.

צרו אתר שלגוגל יהיה קל לסרוק – Crawlable Website

כברירת מחדל, מרבית האתרים הם נגישים למנועי חיפוש.

למעשה, אם הינכם עובדים עם אחת המערכות הבאות, לא צריכה להיות לכם שום בעיה עם סריקה בגוגל:

- אתרי HTML נקיים ללא מערכת ניהול

- וורדפרס (עוד על קידום אתרי וורדפרס)

- ג'ומלה

- וויקס

- מג'נטו

- דרופל

- Prestashop

- קונימבו

- ועוד אינספור מערכת ניהול תוכן (CMS) מוכרות יותר או פחות

יחד עם זאת, עם התקדמות הטכנולוגיה ושפות אינטרנט וסקריפטים שונים (לדוגמא אנגולר, Ajax, React וכו') נושא הזחילה שאמור להיות מובן מאליו, הופך להיות מאתגר.

עד לפני מספר שנים לא גדול, לעכבישים של גוגל היה מאתגר להתמודד עם שפת Javascript, שהיום היא נפוצה כמעט כמו HTML.

גוגל השתפרו רבות ביכולת שלהם לסרוק JS וגם שפות תכנות נוספות, אבל תמיד יש טכנולוגיות חדשות שמאתגרות את הבוטים שלהם.

במקרים בהם אתרים בנויים בטכנולוגיות אלו, והם מיועדים להתאנדקס ולהיות מקודמים – יש פתרונות שונים המאפשרים להנגיש אותם לגוגל ולשאר מנועי החיפוש בצורה אופטימלית.

במקרה ויש לכם אתר מבוסס קוד / תשתית מורכבת, או שאתם צריכים לקדם אתר כזה, מצרף פה כמה מדריכים רלוונטיים:

- קידום אתרי אנגולר – מאת עידן בן אור

- הנגשת אתרי AJAX לסריקה (מדריך טכני באנגלית מאת גוגל)

הפלטפורמה עליה מבוסס האתר היא לא הפרמטר היחיד הקובע את קלות הסריקה / ידידותיות האתר עבור גוגל, אלא גם המבנה וההיררכיה.

מבנה והיררכיה של אתר אינטרנט

הזכרתי מקודם על העכבישים של גוגל וכיצד הם עוקבים אחרי קישורים פנימיים וחיצוניים על מנת למצוא עמודים חדשים (או קיימים) ולאנדקס / לעדכן אותם באינדקס במידת הצורך.

לכן, המצב האידיאלי הוא לבנות אתר שבו כל העמודים נגישים מהתפריט הראשי או המשני במרחק של עד 3 קליקים.

זאת אומרת, שלא משנה מאיזה עמוד אני מתחיל, אני אוכל להגיע לכל עמוד אחר באתר במרחק של 3 לחיצות לכל היותר.

זאת לא נוסחא מדעית או משהו כזה, אבל כלל אצבע שכדאי לקחת בחשבון.

אני למשל, משתמש כמו שאולי שמתם לב, המון בקישורים פנימיים (כתבתי על זה מדריך שלם) וגם גדולים ממני עושים את זה – ויקיפדיה למשל.

טיפים נוספים למבנה והיררכיה אידיאליים לסריקה:

- תפריט מקיף המקשר לעמודים מרכזיים שמהם יש קישורים לשאר העמודים באתר – אצלי למשל בחרתי להנגיש את כל הקטגוריות בבלוג מהתפריט העליון – על מנת להקל על גוגל (וכמובן גם על המשתמשים) במציאת תכנים על פי נושא רלוונטי.

- קישורים פנימיים בין העמודים – כפי שכבר הזכרתי, חשוב לשלב אותם גם בתוכן עצמו אבל גם בין קטגוריות לעמודים, בין עמודים לפוסטים, פוסטים לעמודים וכו'

- שימוש בתגיות – תגיות זה עניין טריקי. הרבה מאד אתרים עושים בזה שימוש לא נכון, מה שמייצר עמודי זבל באתר (עמודים שנרצה להעיף מאינדקס כדי להימנע מפגיעה כוללת בציון האתר). אבל תגיות יכולות להיות גם יעילות לסריקה ואינדוקס של עמודים שהם עמוקים בהיררכיה של האתר.

למעשה תגיות הן סוג של השלמה לקטגוריות וניתן בעזרתן לסווג פוסטים (מאמרים) לתתי נושאים שפחות מתאימים לקטגוריות ויותר ספציפיים באופי שלהם – למשל שמות של בני אדם, חברות, תחומים ספציפיים ועוד. - שימוש בסיילו (SILO) / שיטת המיכלים – בגדול, גישה של סידור היררכיה בתפריט בצורה של נושאים -> תתי נושאים -> תתי תתי נושאים ועוד. המדריך הזה מסביר את זה בצורה ויזואלית יפה.

מפת אתר / Sitemaps

מפת אתר (Sitemap) אפשר לחלק ל-2:

- מפת אתר מסוג XML – מעין קובץ המכיל את רשימת עמודי האתר במטרה להגיש לגוגל לסריקה מהירה ויעילה של עמודי האתר. את הקובץ מגישים באמצעות ה-Search Console שכבר הזכרתי מקודם.

- מפת אתר פיזית – זה למעשה עמוד לכל דבר באתר, המכיל רשימה מסודרת של עמודי האתר. הרבה פחות נפוץ לראות עמודים כאלה באתרים של היום.

לא ארחיב יותר מדי על מפות אתר כי כבר כתבתי על זה מדריך, אבל בגדול מה שחשוב לדעת:

- ממש אין חובה לייצר מפת אתר כדי שגוגל יאנדקס את האתר כמו שצריך

- רוב המערכות מייצרות מפת אתר XML אוטומטית (למשל Yoast בוורדפרס).

- מנסיון, הגשת מפת אתר לגוגל יכולה משמעותית לזרז סריקה של אתרים חדשים (וגם רענון של אתר קיים)

מצרף סרטון של קולגה וחבר שמוליק דורינבאום שמסביר יפה (כמו תמיד) על מפת אתר:

קובץ Robots.txt

כשמדברים על איך גוגל עובד, קשר שלא להזכיר את הקובץ robots.txt.

קובץ רובוטס יושב על התיקיה הראשית של הדומיין ותפקידו לתת הוראות לגוגל ושאר מנועי חיפוש, אילוי עמודים לסרוק ואילו לא. זהו הקובץ הראשון שמנועי החיפוש מבקרים בו לפני שסורקים את האתר בכל פעם.

בדומה למפת אתר, גם קובץ Robots.txt אינו חובה.

בעזרת קובץ Robots.txt, ניתן לחסום תיקיות שלמות מסריקה ואינדוקס (למשל תיקיות של מערכת הניהול) וגם נתיבים ספציפיים שאנחנו רוצים למנוע אינדוקס שלהם – למשל פרמטרים של חיפוש או פילטור (נפוץ באתרי מסחר אך לא רק).

קטי ניימרק עשתה מדריך יפה על קובץ Robots, אם בא לכם להרחיב בנושא:

אוקיי. אז איך גוגל מדרג את תוצאות החיפוש?

עד עכשיו דיברתי על איך גוגל עובד – בדגש על הצד הטכני של מנוע החיפוש. הרחבתי על מושגים כמו סריקה, אינדוקס ושות'.

האמת שסריקה ואינדוקס זה החלק הקל בכל הנושא של קידום אורגני.

החלק המאתגר יותר – זה לגרום לגוגל לדרג את העמודים שלכם בעמוד הראשון.

איך עושים את זה? זה כבר תורה בפני עצמה. אני לא אחפור על הכל במדריך הנוכחי כי כל המידע הזה קיים ובהרחבה אצלי באתר במדריכים אחרים.

אם מעניין אתכם להתעמק בנושא, אפנה אתכם למדריך קידום אתרים שלי, שמסתעף לתוך הרבה מדריכים ספציפיים בכל הנושאים שקשורים לקידום בגוגל כמו: קישורים, אופטימיזציה, תוכן, חווית משתמש ועוד.

אם אתם עצלנים ולא בא לכם להיכנס למדריכים נוספים, רק אסביר בגדול (אבל ממש בגדול) שישנם 3 גורמים מרכזיים שבאמצעותם אלגוריתם החיפוש של גוגל קובע את הדירוג של תוצאת חיפוש, והן:

- תוכן – איכות, כמות, אורך, חווית המשתמש, וכו'

- אופטימיזציה – עד כמה התוכן תואם לכוונת הגולש, מהירות האתר, אופטימיזציה טכנית של קוד ועוד

- קישורים ואזכורים של האתר באתרים אחרים, מהם נגזרת סמכותיות האתר (למידע נוסף קיראו על TrustRank).

כל ה-200 פרמטרים שהזכרתי מקודם? כל אחד מהם פחות או יותר קשור לאחד משלושת הסעיפים האלו. דבר נוסף שכדאי להכיר זה RankBrain – אלגוריתם הליבה של גוגל החל משנת 2015.

אז מה נעשה עם כל זה?

אני מקווה שהצלחתי להציג בפניכם בקווים כללים וברורים (עד כמה שניתן) את האופן שבו מנוע החיפוש של גוגל עובד.

בתור מקדמי אתרים, מקצועיים או חובבנים, אתם יכולים לקחת את המידע הזה (ביחד עם כל המדריכים הנוספים שהזכרתי וקישרתי אליהם מהמאמר הנוכחי) ולנסח עבור עצמכם כמה שאלות שיעזרו לכם לגבש תכנית פעולה לקידום מוצלח של אתרכם.

הנה כמה רעיונות:

- מהי התכלית של האתר שלי? מהם התוכן או השרות שאני מציע?

- באיזה מילים או ביטויים הגולשים עשויים להשתמש כשהם מחפשים את מה שאני מציע?

- האם התוכן באתר שלי נותן מענה לשאלות האלה? האם המענה הזה ברור לגולשים? איך המענה ביחס למתחרים?

- האם המילים והביטויים שהגולשים שלי מחפשים מופיעים בתוכן האתר?

- האם האתר שלי בנוי באופן שהתוכן שלו ברור לגוגל?

- האם האתר שלי מזמין את הגולשים לעיין בתכנים בעומק, ליצור אינטראקציה או לשתף?

- האם האתר שלי נטען מהר ונגיש לכל סוגי המכשירים?

- איך אני הולך לגרום לאחרים לקשר אליי, או לפחות לשתף את התוכן שלי?

התשובות שלכם לשאלות האלו יכולות לעזור לכם להגדיר את המטרות והאמצעים על מנת לבנות אתר איכותי אמין ונגיש, שיזכה לתנועה, עניין ואינטראקציה רבים ולדירוג הגבוה המבוקש בתוצאות החיפוש של גוגל.

מרגישים שכל זה קצת גדול עליכם? ממליץ על המדריך שלי לקידום אתרים למתחילים.

צריכים להתייעץ? בכיף, צרו קשר.

בהצלחה!