אם הינך מקדם אתרים בוודאי שמעת ואתה אולי גם עושה שימוש מדי פעם בקובץ Robots.txt.

במידה ואתה עוסק בקידום אתרים ומעולם לא שמעת על הקובץ הזה – גש לעשות קורס קידום אתרים דחוף (יש לי כזה, מעולה ובחינם).

מה זה קובץ Robots ולמה הוא משמש?

קובץ robots.txt הינו קובץ היושב על התיקייה הראשית של האתר (לדוגמא: domain.co.il/robots.txt) ותפקידו להנחות את מנועי החיפוש השונים (וכמובן גוגל ביניהם) לגבי אילו אזורים באתר שלנו כן לסרוק ולאנדקס ואיזה לא.

כברירת מחדל, מנועי החיפוש יסרקו כל עמוד שימצאו באתר.

על כן, השימוש העיקרי בקובץ רובוטס הוא לחסום תיקיות ואזורים באתר אשר אנו לא רוצים שמנועי החיפוש "יבקרו בהם".

בדרך כלל מדובר בתיקיות ניהול של המערכת, סקריפטים שונים ועוד.

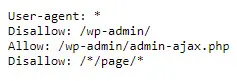

ככה למשל, נראה קובץ robots.txt:

הסבר בסיסי על קובץ robots.txt:

- User-Agent: מגדיר לאיזה מנוע חיפוש מתייחסת הפקודה: למשל גוגל, יאהו, בינג, באיידו וכו'

- Disallow: פקודה שמורה למנוע החיפוש הרלוונטי מאיזה קבצים או תיקיות באתר להתעלם ולמעשה לא לאנדקס

- Allow: פקודה המחריגה ומאפשרת סריקה בתוך תיקיה שנחסמה בעזרת Disallow. אין צורך שתהיה פקודת Allow כללית בקובץ robots.txt כי כאמור, ברירת המחדל של גוגל (ומנועי חיפוש אחרים) היא לסרוק כל דבר אלא אם נאמר להם אחרת.

למה שנרצה לחסום אזורים או עמודים באתר בעזרת קובץ Robots.txt?

במקרים מסוימים, נרצה לחסום למנועי חיפוש גם אזורים באתר אשר נגישים למשתמש.

מקרים נפוצים בהם נרצה לחסום קבצים או תיקיות שלמות באתר שלנו:

- אזור האדמין (ניהול האתר)

- חסימה גורפת של אתר (בזמן הקמה למשל)

- חסימת אזורים באתר שנמצאים בשלבי פיתוח (לפני השקה)

- חסימת אזורים באתר שפתוחים רק למשתמשים מורשים – לדוגמא קורסים בתשלום

- ועוד…

דוגמא נפוצה לחסימת אתר בעזרת קובץ robots.txt – אתרים בפיתוח

שימוש נפוץ בקובץ robots.txt הוא חסימה גורפת של אתרים אשר נמצאים בתהליך בנייה.

למה חוסמים אתרים לגוגל בשלב הבנייה?

הסיבה פשוטה: לא נרצה שגוגל יסרוק אתר שהוא "חצי אפוי".

על מנת לראות את הפוטנציאל האורגני ותוך כמה זמן נכפיל לך את ההכנסות

ניתן לחייג למספר 052-9095200 או למלא את הטופס:

סריקה של אתר שאינו מוכן לעלייה לאוויר, נמצא בשלבי בנייה או בתהליכי שדרוג – יכולה לגרום ל"רושם שלילי" בעיני גוגל, ובכל מה שקשור לגוגל – האינטרס שלנו להיות ביחסים טובים איתם.

במילים אחרות – מומלץ יותר לחסום כל אתר שנמצא בשלב בנייה, ולשחרר את החסימה מהקובץ robots.txt רק לאחר שהאתר עולה לאוויר.

ומה עושים במידה ואני משדרג אתר קיים?

כאשר מדברים על שדרוג אתר קיים – הפרקטיקה המומלצת היא לשכפל את האתר לסביבת פיתוח, לבנות עליה את האתר החדש (או להתחיל אותו מאפס) ומיד לאחר מכן לחסום אותו לסריקה ואינדוקס של גוגל.

חסימה במקרה כזה, נועדה מגוגל לסרוק במקביל את האתר הנוכחי והאתר החדש (שנמצא בשלבה הקמה) ובכך למנוע מצב של תוכן משוכפל, שיכול להסב נזק לא קטן ל-SEO של האתר.

האם קובץ robots.txt הוא חובה?

לא. לא בכל אתר חייב להיות את הקובץ הזה, ובעצם אם אין לנו שום דבר שנרצה לחסום לסריקה, אין סיבה להשתמש בו.

כמו כן, ניתן לבדוק את תקינות הקובץ במידה והאתר שלנו מחובר ל Search Console (לשעבר Webmaster Tools) של גוגל.

דרכים נוספים לחסום עמודים בגוגל

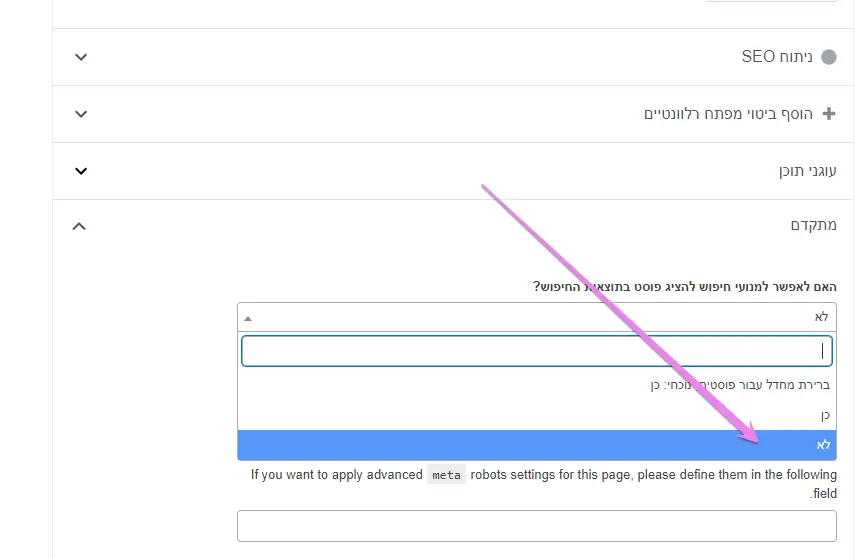

מלבד קובץ robots.txt, שנועד מראש לחסימות גורפות יותר (תיקיות ואזורים שלמים באתר), ניתן גם לחסום עמודים ספציפיים באתר בעזרת פקודת noindex.

זוהי מעין תגית שמוסיפים בקוד של האתר שאומרת למנועי החיפוש "נא לא לאנדקס את העמוד הזה".

במידה ואתם עובדים עם וורדפרס ותוסף Yoast, ככה ניתן להגדיר זאת:

מדריכים נוספים:

6 תגובות

היי תודה רבה על הכתבה!

השאלה שלי היא לדוגמא אני רוצה שגוגל לא יאנדקס את כל הארכיונים שיש לי באתר, וראיתי שהוא כבר אינדקס אותם לצערי, אז אני פשוט מכניס למסמך robots.txt את הפקודה – Disallow /tag ? כי זה מה שעשיתי וכרגע כלום לא השתנה, או שזה פשוט לוקח זמן עד שזה עובד.

בכל מקרה השאלה היא איך אני יודע איזה נתיב להכניס.

תודה מראש 🙂

עמודי ארכיונים הרבה יותר קל לחסום בעזרת הגדרת noindex לסוגי העמודים – ואת זה אפשר לעשות בעזרת תוסף Yoast או תוספים אחרים של SEO.

אחלה אבדוק את זה,

יש לך מושג אולי בערך כמה זמן לוקח לגוגל לעדכן את האתר, כלומר לא לאנדקס יותר את הארכיונים?

יכול לקחת כמה שבועות

שלום, אם אני רוצה שגוגל לא יאנדקס את כל הסינונים באתר מכירתי איך אני כותבת את זה בקובץ robots.txt

מה שקרה, אני מפתחת חנות ווקומרס וחברת האחסון פנתה אלי שגוגל נכנס ללופ ומעמיס באינדוקס בפילטרים של ווקומרס שגורם לעומס על השרת עם מאות אלפי בקשות של כל מיני פילטרים בקטגוריות מוצרים בשילובים שונים בצורה אינסופית למעלה מחודש ללא הפסקה של גוגל בוט, כיצד אני יכולה למנוע מגוגל בוט לאנדקס את הפילטרים משום שגם מתקבל בקונסול מאות אלפי תכנים משוכפלים.

היי, זה לא משהו שאני ממליץ לעשות בלי ידע טכני. הגדרה לא נכונה בקובץ הזה יכולה לעשות נזק משמעותי לקידום האתר. ממליץ לדבר על זה עם מתכנת.

Comments are closed.